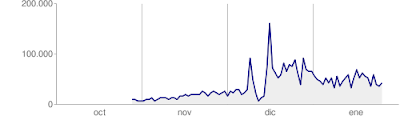

Quería empezar la casa por los cimientos y uno de los primeros objetivos que me propuse fue mejorar la indexación. Creo que esta gráfica de fe de la mejora conseguida.

Como se puede apreciar los resultados tardaron unas semanas en notarse para estabilizarse posteriormente en un nivel muy superior al inicial (más del doble de páginas indexadas).

Lo he conseguido teniendo siempre presente esta máxima:

"a los bots no les gusta que les hagan perder el tiempo"

Dicho de otro modo, hay que optimizar el tiempo que los bots pasan en nuestro site. Si los bots pasan el tiempo accediendo páginas que no se han modificado, que no se encuentran o que están duplicadas, es natural que nos dediquen menos tiempo cada vez y vayan a buscar sitios en los que emplear su tiempo más eficientemente. Si además consultan páginas que no tienen poco interés para nosotros, estamos perdiendo una gran oportunidad.

Qué pasos seguí para "merecer" más atención de los bots?

Análisis previo

- Estudiar la estructura del site

- Configuración y monitorización de googlebot

Estudiar con detenimiento la estructura y jerarquía del sitio Web, clasificando páginas en función de la importancia y actualización de su información, identificando y eliminando páginas repetidas o redundantes, etc.

Todas las páginas de nuestro site son importantes, pero es muy útil establecer una jerarquía si queremos tener más posibilidades de que las más importantes estén más actualizadas en el índice.

Google Webmasters console ofrece distintos parámetros de configuración (localización preferente, velocidad de rastreo, etc) y de monitorización (básicamente errores de rastreo) con los que hay que estar familiarizado.

Acciones

- Asegurar la calidad del sitio

- Reducir el número de páginas a indexar

- Crear un sitemap "ajustado"

Reducir todo lo posible el número de enlaces rotos y mejorar todo lo posible el tiempo de respuesta de nuestras páginas (reducir número o calidad de imágenes, considerar hosting alternativo, etc.)

Depurar el robots.txt para que no haya más de lo que deba haber (eliminar páginas redundantes, formularios, etc)

El sitemap debe reflejar lo más fielmente posible la naturaleza de nuestra información (changefreq y priority apropiados). He visto muchos sitemaps que intentan captar la atención de los bots fijando un "priority=1" para todas las páginas o un "changefreq=always" lo que resulta en la pérdida de beneficios de tener un sitemap. El bot no puede priorizar unas páginas frente a otras ni prever qué páginas son más susceptibles de haberse modificado.

En definitiva todo se limita a aplicar el sentido común, ser meticuloso y no dejarse llevar por la codicia.

Otras entradas relacionadas: